White Paper: Virtualização

Virtualização de Servidor e Gerenciamento de Rede

Resumo Executivo

A virtualização de servidor é a última tendência importante de tecnologia nos data centers. De acordo com o Gartner, a virtualização será a tecnologia de maior impacto na infraestrutura de TI e nas operações de 2012.

O Gartner prevê que a virtualização será a tendência de maior impacto:

www.gartner.com/it

Apesar das limitações, esse recurso tem impactos enormes no ambiente corporativo e na redução de despesas. Os data centers são os maiores beneficiados, pois a virtualização aumenta sua capacidade, estende a vida útil daqueles mais antigos, além de permitir que grandes organizações fechem alguns e, com isso, tenha maior economia. Sem contar que esta é somente a primeira geração de impacto da virtualização.

A segunda permite que múltiplos servidores virtuais compartilhem uma única licença de sistema operacional, proporcionando uma consolidação ainda mais forte. Dessa forma, em torno de 50-100 servidores virtuais funcionam numa única caixa física, a qual pode administrar as aplicações em grandes cargas de computação e, por isso, são consideradas candidatas fracas para uma virtualização de primeira geração.

A virtualização funciona liberando aplicações das limitações de um único servidor físico. Ela permite que uma aplicação use recursos através da rede da empresa. Uma das promessas da virtualização é a capacidade de possibilitar que aplicações se movam dinamicamente de um servidor físico a outro, enquanto as demandas e as disponibilidades de recursos mudam sem que haja interrupção de serviço.A virtualização também exige o uso de redes de área de armazenamento (SANs) e armazenamento separado. Isso leva a rede ainda mais perto do centro da infraestrutura e arquitetura TI.

De um ponto de vista de segurança, centralizar múltiplas aplicações numa única caixa cria únicos pontos de falha, tanto no próprio servidor físico como em sua conexão de rede. Quando um servidor virtualizado cai, ou sua conexão de rede diminui ou quebra, exerce influência sobre todas as aplicações naquela caixa. A implicação para o planejamento de rede é que uma quantidade muito maior de tráfego será centralizada em alguns servidores grandes, ao invés da expansão para fora através de um grande número de

computadores menores no chão do data center.

Além disso, a virtualização opera melhor com armazenamento separado do que anexado. Por isso, é necessária uma conectividade de rede muito rápida e confiável entre servidores e dispositivos de armazenamento na rede de área de armazenamento (SAN). As organizações ao se moverem para armazenamento anexado, como parte da virtualização, criam um grande aumento no tráfego da rede, responsável por aumentar a necessidade por um rigoroso gerenciamento.

Um ambiente altamente virtualizado vive ou morre de acordo com a eficiência e dependência da sua rede de dados. Falhas em um servidor físico, na conexão, interruptor ou roteador podem ser muito caras, quando elas desconectam funcionárioschave, chãos de fábrica automatizados ou operações de comércio online de funcionalidade vital.

O gerenciamento de rede pode fornecer informações essenciais para o planejamento e teste de ambientes virtualizados. Por exemplo, determinar quais aplicações não são boas candidatas para virtualização é primordial. A quantidade e o caráter do tráfego da rede podem fornecer pistas importantes em como identificar essas aplicações.

Por que Virtualização de Servidor?

A virtualização de servidor chegou na hora certa para os departamentos de TI devido à pressão para cortar custos e diante de um cenário com recessão mundial, custos de energia aumentando gradualmente e data centers cada vez mais terceirizados. Ela ataca o problema da baixa utilização de servidores de aplicação única que se proliferam em data centers de médias e grandes empresas. As populações de servidores de muitos ambientes não-virtualizados alcançam em média uma utilização de aproximadamente 20%. O resultado é um desperdício enorme de energia, que acaba sendo duplicado, pois para cada quilowatt usado, uma quantidade igual de refrigeração tem que ser equilibrada a fim de manter os servidores na temperatura ideal de operação.

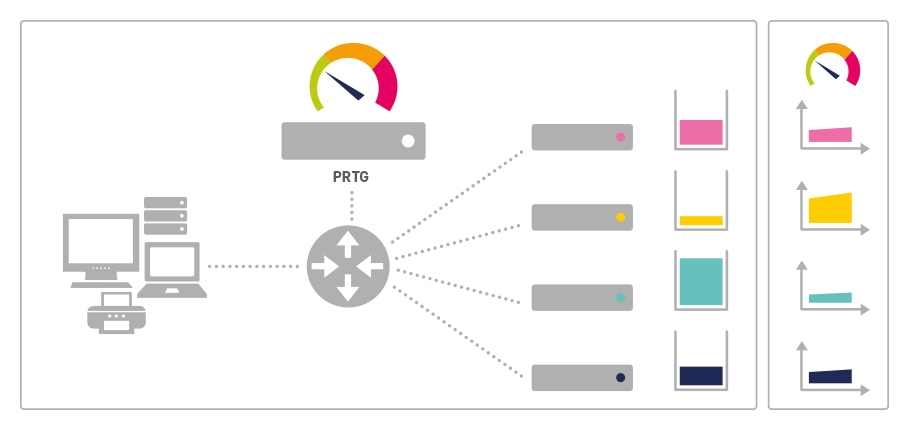

Ambiente Distribuído

FIGURA: Cada aplicação reside

num servidor físico

separado com arma-

zenamento anexado.

Isso tem implicações graves para a vida útil dos data centers, pois um número crescente de instalações precisa cada vez mais de energia, refrigeração e, em alguns casos, mais espaço de chão apesar do aumento de utilização de servidores de lâmina durante os últimos anos. A virtualização evita esse problema automatizando os assuntos do gerenciamento de empilhamento de múltiplas aplicações num único servidor e compartilhamento dos recursos entre eles. Dessa forma, ela permite que as lojas de TI aumentem a utilização de seu servidor para até 80%.

O impacto em uma organização grande é demonstrado pela experiência da BT, no Reino Unido. A empresa obteve uma consolidação 15:1 de seus 3.000 servidores Wintel e economizou aproximadamente 2 megawatts de energia, além de $2,4 milhões em custos anuais de energia. Tais resultados, ajudaram a reduzir os custos de manutenção de servidor em 90%, e a BT se livrou de 225 toneladas de equipamentos (de uma maneira ecologicamente amigável), fechando vários data centers no Reino Unido. Essa economia de custos foi bem notável pelo fato de ter envolvido apenas servidores de Wintel, sendo que a BT também tem uma grande população de servidores Unix, a qual não foi afetada no corte de custos.

A economia da BT no Reino Unido através da virtualização:

http://wikibon.org

A BT não apenas pôde realizar poupanças enormes, evitando parcialmente a necessidade de construir um novo data center com um custo estimado de $120 milhões como também recebeu três grandes prêmios europeus de ecologia devido às reduções no perfil de carbono no programa. Durante esse processo, a empresa continuou expandindo seu negócio gradualmente, o que desacreditou o argumento comum de que as empresas e as nações devem escolher entre essas duas alternativas: ou expandem suas economias ou reduzem seus impactos ambientais.

Longe de prejudicar seu negócio, o projeto da BT adicionou credibilidade à consultoria de negócio verde que ela começou a praticar no começo desta década na União Europeia e nos Estados Unidos. Este não é um exemplo extremo do que pode ser realizado. A BT é claramente uma empresa muito grande. Já empresas menores efetuarão poupanças proporcionalmente menores em números absolutos, mas as porcentagens atrasarão para organizações com populações de 50 ou mais servidores. Isso irá permitir que eles estendam as vidas úteis de seus data centers, assim como economizará com custos de energia.

Gerenciamento de Rede e Virtualização

À primeira vista, talvez pareça que essa virtualização tenha um impacto pequeno no gerenciamento de rede. As mesmas aplicações operam no mesmo data center, porém em diferentes tipos de hardware. No entanto, um olhar mais próximo mostra que isso tem implicações no gerenciamento de rede. A extensão dessas implicações varia, dependendo da arquitetura de prévirtualização. Virtualização total é uma das várias forças combinadas para dirigir a rede no centro da infraestrutura de TI e substituir o computador central. Isso aumenta a importância das operações de rede e o impacto potencial de interrupções, fazendo com que um forte gerenciamento seja vital no cenário empresarial de hoje.

Como funciona a virtualização

Concentração de aplicações

Primeiramente, a virtualização centraliza aplicações em um ou relativamente poucos servidores físicos, tornando-os os únicos pontos de falha, que possam ter um impacto importante nas operações de negócio. Quem se lembra das operações de tela-verde dos anos 80 sabe que quando o computador central falhava, todo o trabalho no escritório parava. A queda de um único interruptor de rede ou roteador num ambiente altamente virtualizado pode gerar um impacto semelhante, cortando acesso de até 50-100 aplicações vitais.

Uma ferramenta de gerenciamento de rede, tal como o PRTG Network Monitor da Paessler, pode fornecer notificação instantânea em caso de falha de um servidor Windows ou sua conexão de rede. Assim, é possível que o departamento de TI aja de modo imediato para reduzir o impacto do choque.

Soluções de armazenamento e virtualização

Em um ambiente multisservidor, isso envolve a migração de armazenamento anexado direto, em que as unidades de disco são anexadas diretamente ao servidor da mesma forma como elas estão na área de trabalho de computadores portáteis para diferentes

sistemas de armazenamento. Assim, as unidades de disco operam em uma rede de área de armazenamento (SAN), tornando-se parte da infraestrutura total da rede. Essa migração tem continuado desde o final dos anos 90 e existem várias vantagens em termos de flexibilidade e proteção de dados. Ela acelera enquanto o servidor de virtualização consolida seus caminhos até as lojas online que ainda executam aplicativos com armazenamento diretamente conectado.

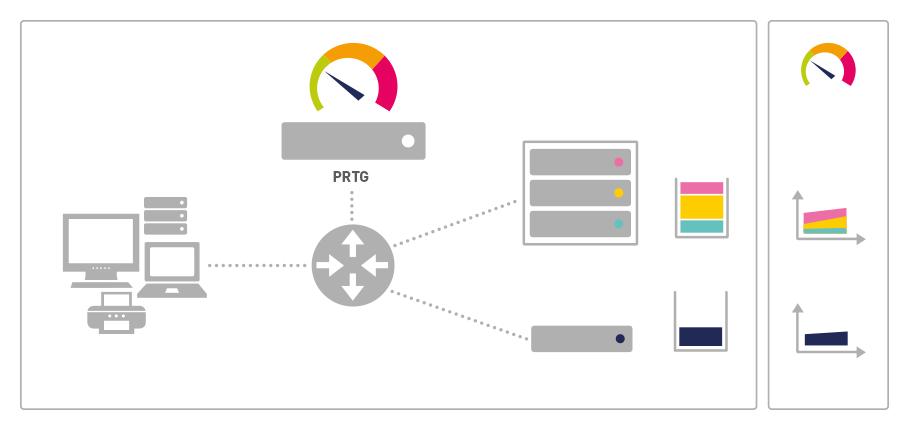

Consolidado Por Virtualização

FIGURA: As três aplicações

funcionam em um ambiente

virtual compartilhando os

recursos do servidor de

virtualização

A desvantagem é que todo o acesso entre aplicações e dados deve ocorrer através da rede e até mesmo pequenos atrasos podem criar problemas com muitas aplicações. Assim, ambientes virtualizados não podem tolerar sobrecargas de rede ou falhas de interruptores. Por isso, é necessário um forte gerenciamento de rede. Ferramentas de monitoramento realizam um gerenciamento em tempo real dos pontos críticos da rede, através de gráficos de tráfego de rede e projeções de uso a longo prazo. Isso ajuda os gerentes de TI a prever aumentos no tráfego, antes que estes afetem os níveis de serviço.

Aplicações Inadequadas para Virtualização

As aplicações com cargas mais pesadas de computação ou leitura/escritura de dados não provaram ser boas candidatas para virtualização de hipervisor. Como resultado, a virtualização no ramo de atacado pode criar sérios problemas no nível de serviços. No entanto, identificar quais aplicações devem permanecer em servidores dedicados, nem sempre é uma tarefa fácil. O volume e caráter das transmissões para essas aplicações fornecem pistas importantes em como identificar as aplicações. Uma ferramenta forte de gerenciamento de rede, tal como PRTG Network Monitor, é a melhor fonte para essas informações vitais.

Virtualizações e Gerenciamento de Recursos

A virtualização de servidor promete mudanças dinâmicas dos recursos subjacentes de computação e armazenamento para atender a picos de demanda em aplicações individuais. Essa é a principal forma de aumentar a eficiência na alocação de recursos. Ambientes não virtualizados são caracterizados por tal utilização baixa devido ao fato de que cada aplicação necessita energia e memória de computador suficiente para atender à sua carga máxima mais um adicional para acomodar crescimentos futuros. É frequen-temente difícil antecipar a velocidade de crescimento, que tende a seguir um gráfico "taco hóquei" antes que uma curva lisa de uso seja baixa, enquanto operadores aprendem uma nova aplicação.

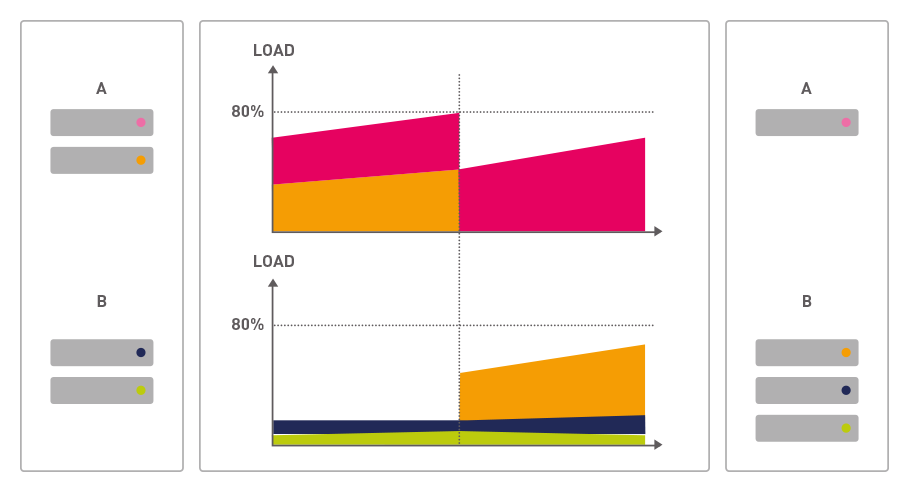

Equilíbrio de Cargas

FIGURA: Com crescente aceitação

de operador, uma nova

aplicação (vermelho) pode

exigir mais recursos. Isso

pode ser facilmente realizado

em Tx movendo uma aplicação

(azul) para outra máquina virtual.

Frequentemente muitas aplicações experimentam variações cíclicas importantes nas demandas, que podem ser semanais, mensais ou anuais. O setor de finanças é o exemplo óbvio de aplicações com ciclos muito grandes de uso mensais e trimestrais, mas também existem muitos outros. Ou seja, em um ambiente não virtualizado, cada aplicação tem que ter recursos de computação suficientes para entregar níveis prometidos de serviço sob a carga anual máxima. Para algumas aplicações, isto significa um investimento forte em recursos de computação, que permanecerão inativos na maior parte do tempo.

A virtualização resolve este problema fornecendo relocação dinâmica de recursos do computador. Demandas nas aplicações separadas correndo em um mesmo centro de dados pode então operar em ciclos diferentes. Uma aplicação encarando um aumento na demanda em um determinado momento pode "emprestar" recursos de outro ciclo, que por sua vez se encontra em um período de baixa demanda.

No caso extremo, fornecedores de virtualização prometem a capacidade mover dinamicamente uma aplicação inteira através da rede de um servidor a outro para responder a tais variações. Por fim, isto implica que todos os servidores e dispositivos de armazenamento operando em ambientes virtualizados possam - por motivos de planejamento - ser tratados como uma grande máquina. Seus recursos são amontoados juntos para atender à demanda total de todos os softwares virtualizados funcionando neles.

Como uma questão prática, isto só pode ocorrer dentro de um único centro de dados, já que atrasos de transmissão entre centros poderiam causar problemas de desempenho. E ele simplesmente não funcionará a menos que a rede ligando estes servidores físicos

seja rápida e altamente tolerante a falhas. Isso exige altos níveis de gerenciamento de redes para garantir o bom desempenho.

A Virtualização e a Paessler

A Paessler oferece três aplicações que formam um conjunto completo de monitoramento de rede para pequenas e médias empresas, mas que também são usadas por grandes companhias com o objetivo de fornecer visibilidade mais detalhada nas partes críticas de suas redes. A Paessler rearquitetou recentemente todas as suas ferramentas, trazendo-as para uma base tecnológica ideal, melhorando sua funcionalidade total, eficiência e usabilidade.

Seu conjunto de ferramenta consiste em: PRTG Network Monitor: trata-se de um aplicativo Windows fácil de usar para monitorar e classificar o uso da banda e vigiar os tempos de disponibilidade/inatividade da rede. O software fornece leituras ao vivo e tendências a longo prazo sobre o uso dos dispositivos da rede. O PRTG torna a detecção precoce de problemas de rede algo fácil e acessível, além de ajudar organizações a controlar seus recursos críticos de rede e detectar imediatamente falhas de sistemas ou problemas de desempenho, reduzindo tempos de inatividade e seu impacto econômico.

O Ajudante de SNMP habilita o PRTG Network Monitor a recolher informações detalhadas de desempenho em workstations e servidores Windows. Até vários mil parâmetros e indicadores de desempenho num PC podem ser monitorados em somente alguns cliques. Ferramenta de Estresse de Servidor: é uma poderosa aplicação de teste HTTP-cliente/ servidor projetada para identificar problemas de desempenho crítico em um site ou servidor web que possam obstruir o fornecimento de uma excelente experiência ao usuário.

Ao simular acesso simultâneo por centenas ou milhares de operadores simultâneos, ela testa o desempenho do servidor web sob cargas normais e extremas, para assegurar que informações críticas e o serviço estejam disponíveis no tempo de resposta que os usuários esperam. Todas essas ferramentas estão disponíveis em várias edições e incluem uma edição gratuita para permitir que operadores testem suas características principais, antes de fazer a decisão de compra.